通义千问团队对 Qwen-VL 模型进行重大更新——推出 Qwen2-VL。2023年8月,通义千问开源第一代视觉语言理解模型Qwen-VL,目前模型下载量突破1000万次。

本次Qwen2-VL开源了两个尺寸的模型,Qwen2-VL-2B-Instruct 和 Qwen2-VL-7B-Instruct,以及其GPTQ和AWQ的量化版本。

Qwen2-VL 新功能

- 增强的图像理解能力:Qwen2-VL显著提高了模型理解和解释视觉信息的能力,为关键性能指标设定了新的基准

- 高级视频理解能力:Qwen2-VL具有卓越的在线流媒体功能,能够以很高的精度实时分析动态视频内容

- 集成的可视化agent功能:Qwen2-VL 现在无缝整合了复杂的系统集成,将 Qwen2-VL 转变为能够进行复杂推理和决策的强大可视化代理

- 扩展的多语言支持:Qwen2-VL 扩展了语言能力,以更好地服务于多样化的全球用户群,使 Qwen2-VL 在不同语言环境中更易于访问和有效

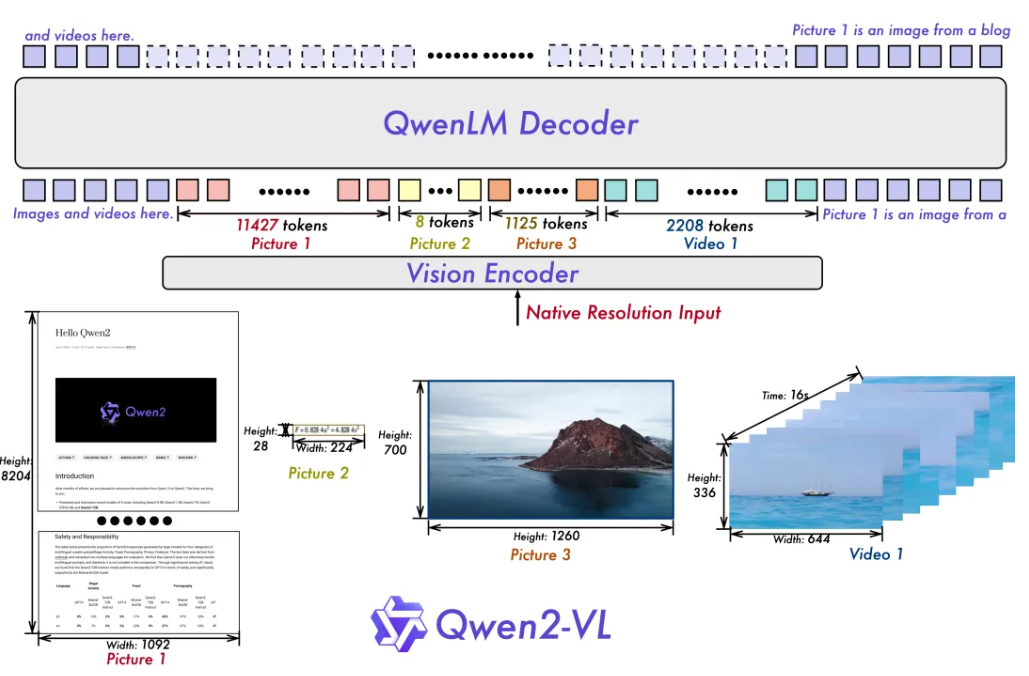

模型结构

Qwen2-VL 的一项关键架构改进是实现了动态分辨率支持(Naive Dynamic Resolution support)。与上一代模型Qwen-VL不同,Qwen2-VL 可以处理任意分辨率的图像,而无需将其分割成块,从而确保模型输入与图像固有信息之间的一致性。这种方法更接近地模仿人类的视觉感知,使模型能够处理任何清晰度或大小的图像。

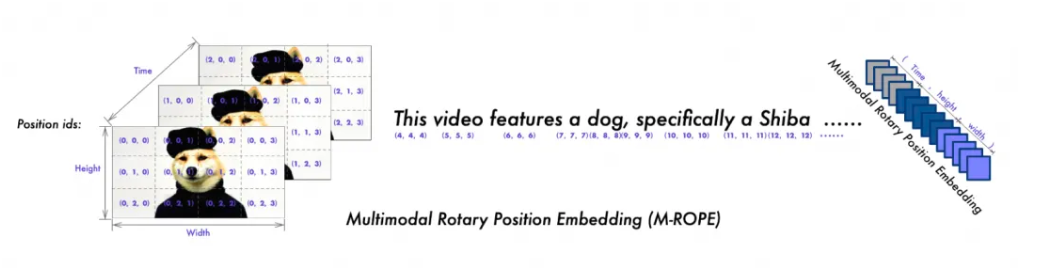

另一个关键的架构增强是Multimodal Rotary Position Embedding (M-ROPE) 的创新。通过将original rotary embedding分解为代表时间和空间(高度和宽度)信息的三个部分,M-ROPE 使 LLM 能够同时捕获和集成 1D 文本、2D视觉和 3D 视频位置信息。这使 LLM 能够充当强大的多模态处理器和推理器。

模型效果

在 7B 规模下,Qwen2-VL-7B成功保留了对图像、多图像和视频输入的支持,以更具成本效益的模型大小提供具有竞争力的性能。具体而言,Qwen2-VL-7B在文档理解任务(例如 DocVQA)和通过 MTVQA 评估的图像多语言文本理解方面表现出色,建立了非常优秀的性能。

本次Qwen2-VL推出一款更小的 2B 模型,该模型针对潜在的移动部署进行了优化。尽管参数量只有2B,但该模型在图像、视频和多语言理解方面表现出色。与其他类似规模的模型相比,它在视频相关任务、文档理解和一般场景问答方面表现尤为出色。