大家好,《RWKV 社区最新动态》迎来了第三期内容,本期统计了 RWKV 社区 7 月的重要动态,一起来看看吧!

省流版本:

- RWKV 官方公告

- RWKV-6-World 14B 模型已发布

- RWKV 中文官网 rwkv.cn 正式上线

- RWKV 社区新项目

- RWKV RAG:一键式 RWKV RAG 本地搭建项目,实现了最小封装和极高的扩展性

- RWKV-Keras:RWKV 的 Keras 实现,支持 RWKV 模型和 State 的推理和训练

- rwkv6-keras-operator:RWKV6 模块的 RWKV 核算子,已发 PIP 包

- RWKV Runner:更新版本并启动易用性改版计划,正在招募前端贡献者

- RWKV 的新学术研究:

- GoldFinch:RWKV/Transformer 混合模型架构

- Restore-RWKV:RWKV 医学图像修复模型

- Decision-RWKV:基于 RWKV 模型的机器人终身学习算法

- 8 月预告:RWKV 的小说微调模型(7B、14B)正在训练中,有望在 8 月发布!

RWKV 官方动态

RWKV-6-World 14B 开源发布

2024 年 7 月 19 日,RWKV 开源基金会宣布正式向全球开源 RWKV-6-World 14B 模型。

RWKV-6-World 14B 是迄今最强的稠密纯 RNN 大语言模型。在最新的性能测试中,该模型英文性能相当于 Llama2 13b。在同参数的模型评测中,RWKV-6-World 14B 的多语言性能显著最强,且支持全球 100+种语言和代码。

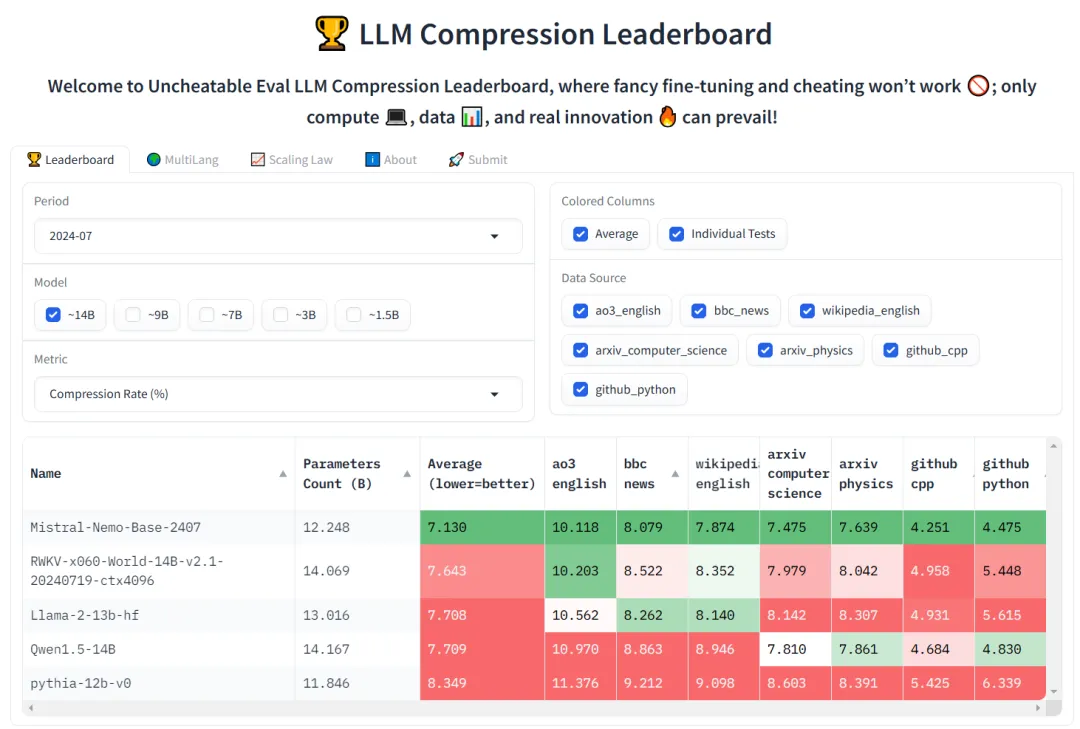

在“无法作弊的模型评测” Uncheatable Eval 排行榜中,RWKV-6-World 14B 的综合评测分数比 llama2 13B 和 Qwen1.5 14B 更强。

RWKV 中文官网正式上线

RWKV 中文官网(rwkv.cn)正式上线了,RWKV 中文官网目前有四大板块,分别是首页、生态页、资讯页,以及 RWKV 中文文档页面。

你可以在 RWKV 中文官网找到关于 RWKV 的绝大多数信息,包括但不限于 RWKV 架构的介绍、RWKV 多模态等研究和相关论文、RWKV 的本地部署和推理教程、RWKV 的全参/微调训练教程,以及 RWKV 最新新闻动态等信息。

RWKV 社区的新项目/更新

RWKV RAG 项目

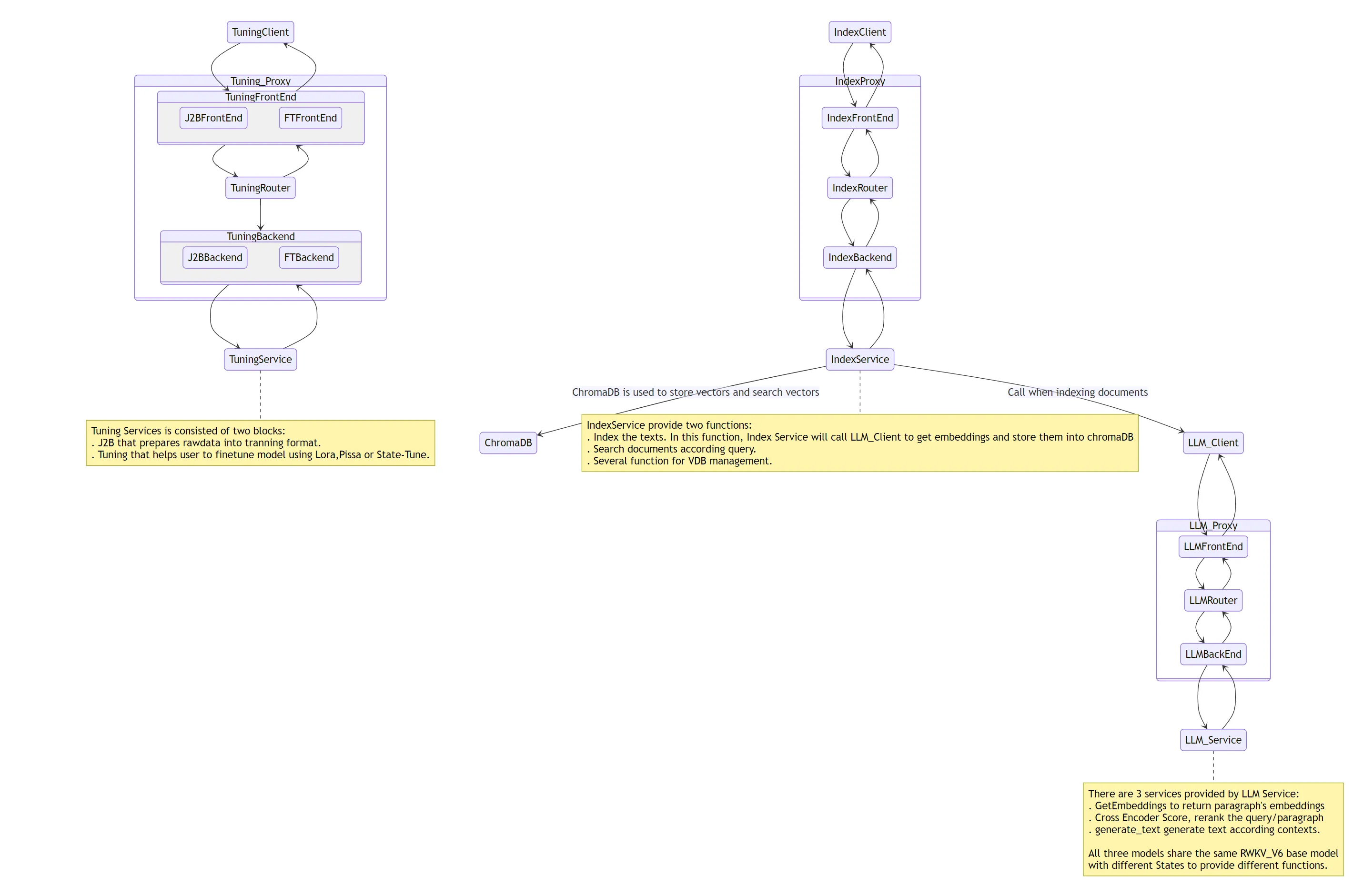

RWKV_RAG 是 RWKV 的本地 RAG 项目,实现了傻瓜式的本地 RWKV RAG 系统搭建流程。

RWKV_RAG 架构实现了实现了最小封装和高扩展性:所有功能异步化且无封装,想怎么调接口就怎么调接口。

此外,RWKV_RAG 已支持带图形化界面的 LoRA、State tuning、Pissa 等主流 RWKV 微调方法,可以一键微调以适应任何下游任务。

RWKV_RAG 很快会适配多模态和知识图谱功能,敬请期待!

RWKV-RAG 仓库地址: https://github.com/AIIRWKV/RWKV_RAG

RWKV6-Keras

RWKV6-Keras 项目是基于 RWKV 模型的 Keras 实现,由 RWKV 社区的 infiy-quine 兴趣组牵头开发,基于 bert4keras3 和 RWKV6_Keras 算子两个项目。

除了支持训练和推理 RWKV 模型,RWKV6-Keras 还支持 RWKV State 的训练和推理。

以下是 RWKV6-Keras 基于不同后端的生成速度对比:

| 前置条件 | torch(keras) | jax(keras) | tensorflow(keras) | RWKV-Pytorch |

|---|---|---|---|---|

| 有 cuda 算子(bs=1) | 4 token/s | 78.0 token/s | / | / |

| 无 cuda 算子(bs=1) | 4 token/s | 77.0 token/s | 77.0 token/s | 25.75 tokens/s |

| 有 cuda 算子(bs=64) | / | 1500.0 token/s | / | / |

| 无 cuda 算子(bs=64) | / | 1289.0 token/s | / | 578.68 tokens/s |

| prefill(有 cuda) | 185ms | 5ms | / | / |

| prefill(无 cuda) | 6s | 209ms | 186ms | 480 ms |

对比测试显示,更推荐使用 jax 作为 RWKV6-Keras 后端,以获得最佳性能。

RWKV6-Keras 模型下载:https://www.modelscope.cn/models/q935499957/RWKV6-1.6B-Keras

rwkv6-keras-operator 项目

rwkv6-keras-operator 是一个适用于 bert4keras3 库中 RWKV6 模块的 RWKV 核算子,这个算子在 jax、pytorch 框架提供了原生 CUDA 实现,但对于 TensorFlow 框架只提供基本的上层 api 实现。

- RWKV6_Keras 算子 pip 包地址:https://pypi.org/project/rwkv6-keras-operator

- GitHub 仓库:https://github.com/infiy-quine/RWKV6_Keras_Operator

rwkv.cpp 新增 RWKV-6 支持

rwkv.cpp 项目新增了对于 RWKV-6 架构的支持,这意味着 RWKV-6 模型可以在 CPU 上实现较快的推理速度。

详情可见:https://github.com/RWKV/rwkv.cpp/pull/174

在 1.8.5 版本的更新中 ,RWKV Runner 的 rwkv.cpp 模式也同步支持 RWKV-6 架构。

RWKV Runner 项目更新

1. RWKV Runner 发布 1.8.5 版本

RWKV Runner 更新到了 v1.8.5,新版本支持了开发者工具,允许用户自定义头像,并且修复了一些已知问题。

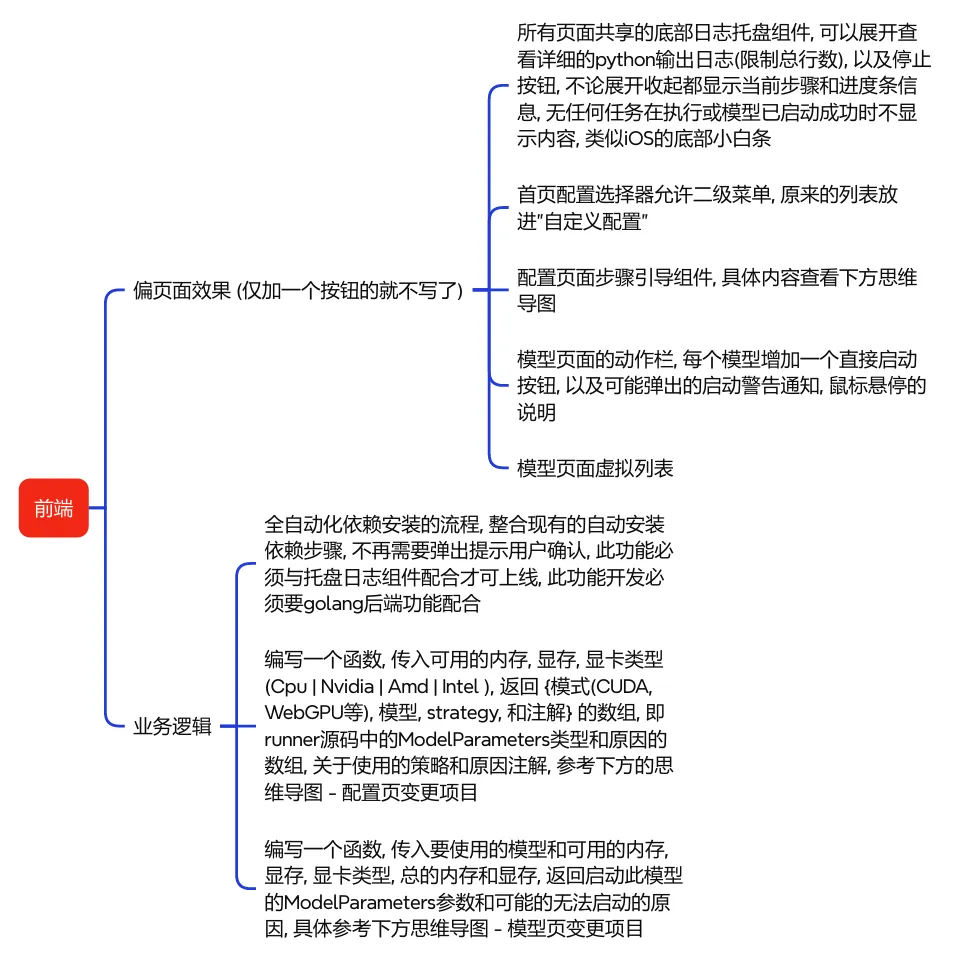

2. RWKV Runner 易用性改版

RWKV Runner 正在启动易用性改版计划,使得软件更开箱即用,对新手更友好。

易用性改版主要围绕前端板块展开,具体任务如下:

RWKV Runner 开发组正在寻找有意向参与改版的前端高手(技术栈 react, typescript, tailwindcss),以加快改版的进度。如果您有意向参与到改版计划,欢迎在“RWKV元始智能”公众号后台留言“改版计划”,我们将第一时间联系您。

Runner API 指南

RWKV 社区发布了关于 RWKV Runner API 的详细用法。文章列出 RWKV Runner 每一个 API 的作用、请求主体的参考结构、必需字段和可选字段等内容,帮助大家更轻松、更灵活地调用 RWKV Runner 的 API。

Runner API 使用指南:https://mp.weixin.qq.com/s/ZU9vpBa6cRMe-0PmrZkJew

RWKV 学术研究相关

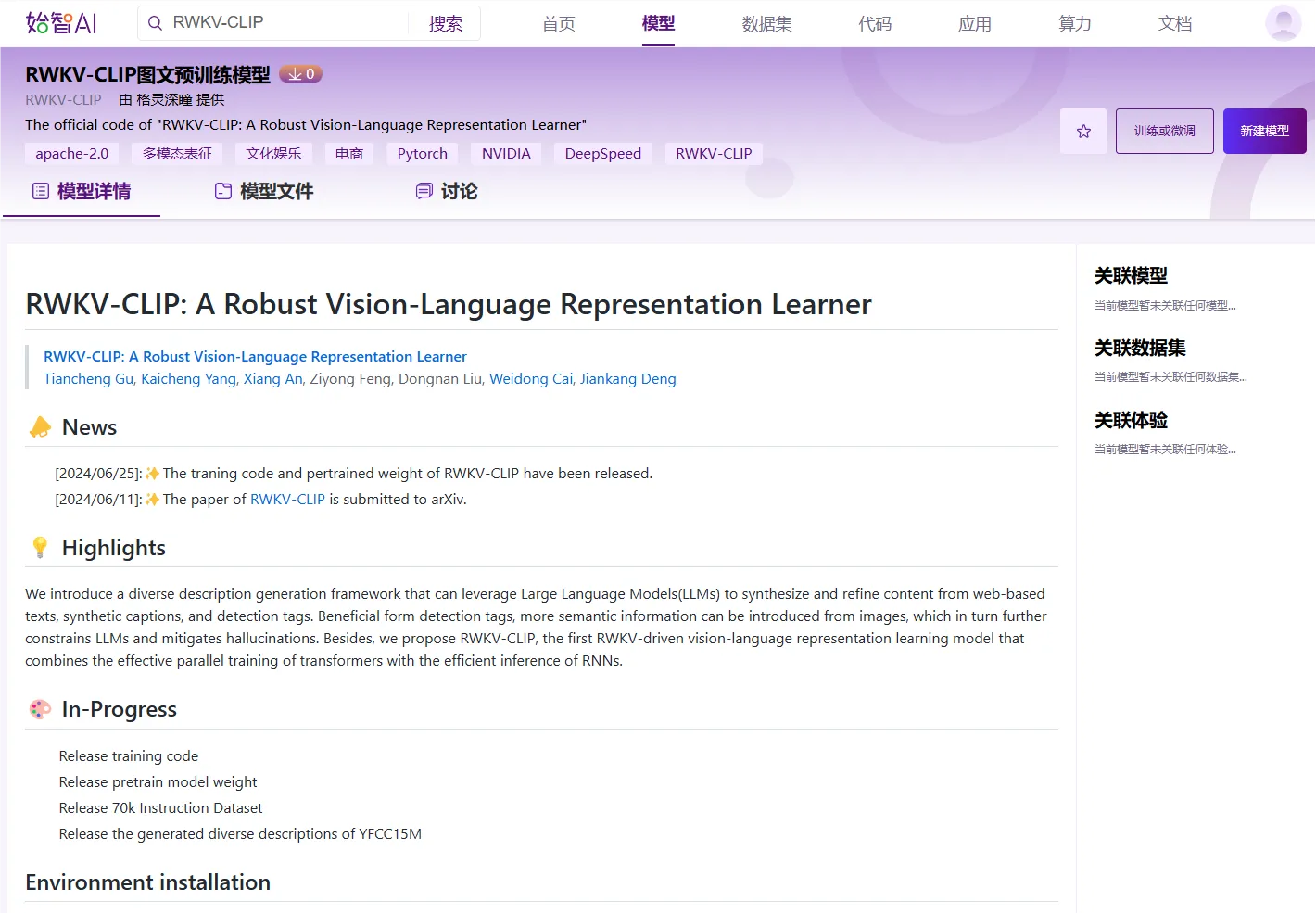

格灵深瞳开源 RWKV-CLIP 模型

格灵深瞳近日在 WiseModel 平台上开源了 RWKV-CLIP 模型,RWKV-CLIP (Contrastive Language-Image Pre-training)是一个 RWKV 驱动的视觉语言表示学习模型,该框架可以利用大型语言模型(LLMs)来合成和细化基于网络的文本、合成标题和检测标签的内容。

-

RWKV-CLIP 模型下载:https://wisemodel.cn/models/deepglint/RWKV-CLIP/file

RWKV-CLIP 更多链接:

- RWKV-CLIP GitHub 仓库:https://github.com/deepglint/RWKV-CLIP

- RWKV-CLIP 论文地址:https://arxiv.org/abs/2406.06973

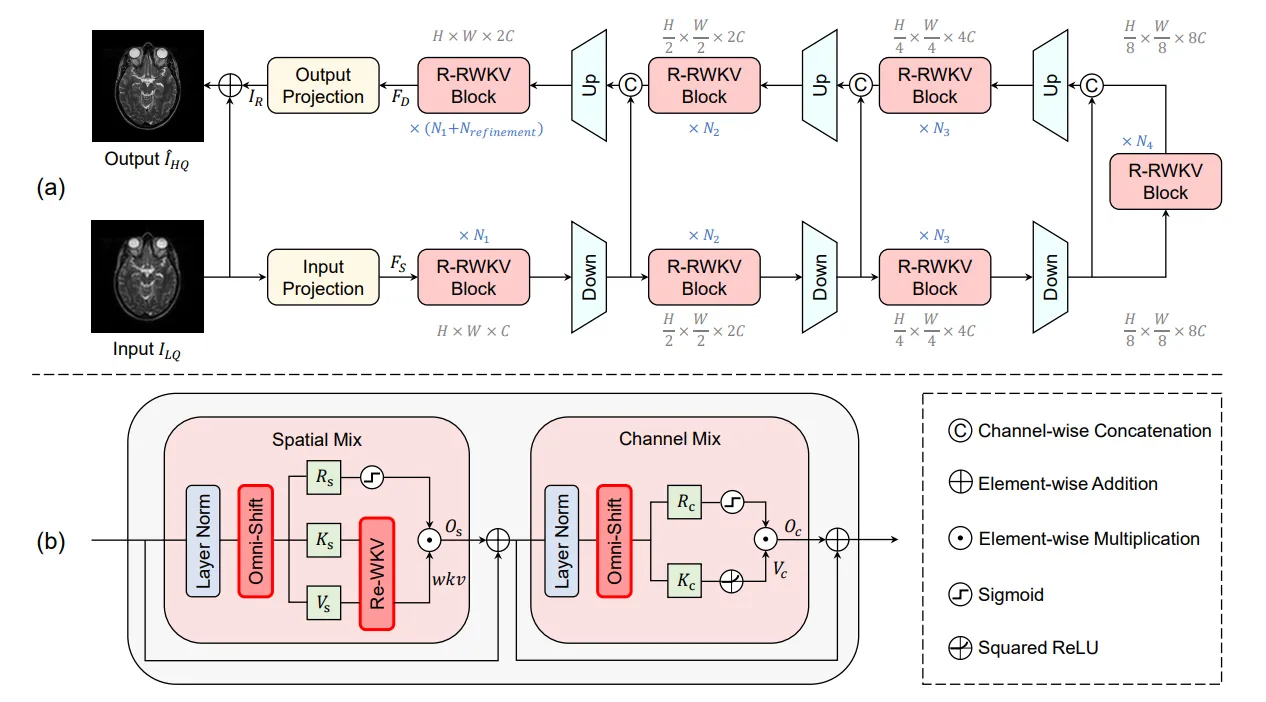

Restore-RWKV

Restore-RWKV 是首个基于 RWKV 的医学图像修复模型。文章提出了一种循环 WKV(Re-WKV)注意力机制,该机制以线性计算复杂度捕获全局依赖关系。Restore-RWKV 在各种医学图像修复任务中均具有卓越的性能,包括 MRI 图像超分辨率、CT 图像去噪 PET 图像合成和一体化医学图像修复。

相关链接:

- Restore-RWKV 论文地址:https://arxiv.org/abs/2407.11087

- Restore-RWKV GitHub 仓库:https://github.com/Yaziwel/Restore-RWKV

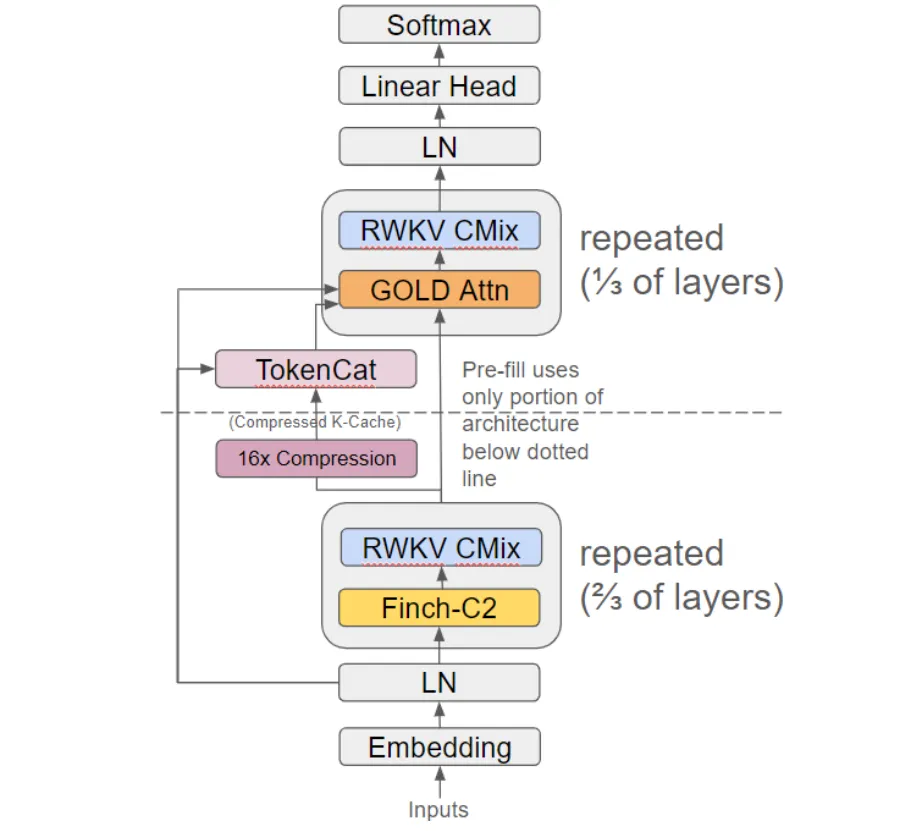

GoldRWKV

GoldFinch 是一种 RWKV/Transformer 混合序列模型,将新的 GOLD transformer 叠加在 Finch(RWKV-6) 架构的增强版本之上,有效地在线性时间和空间中生成高度压缩和可重用的 KV-Cache。相对于 1.5B 参数的 Finch 和 Llama 模型而言,GoldFinch 的建模性能显着提高。

相关链接:

- GoldFinch 论文地址:https://arxiv.org/abs/2407.12077

- GoldFinch GitHub 仓库:https://github.com/recursal/GoldFinch-paper

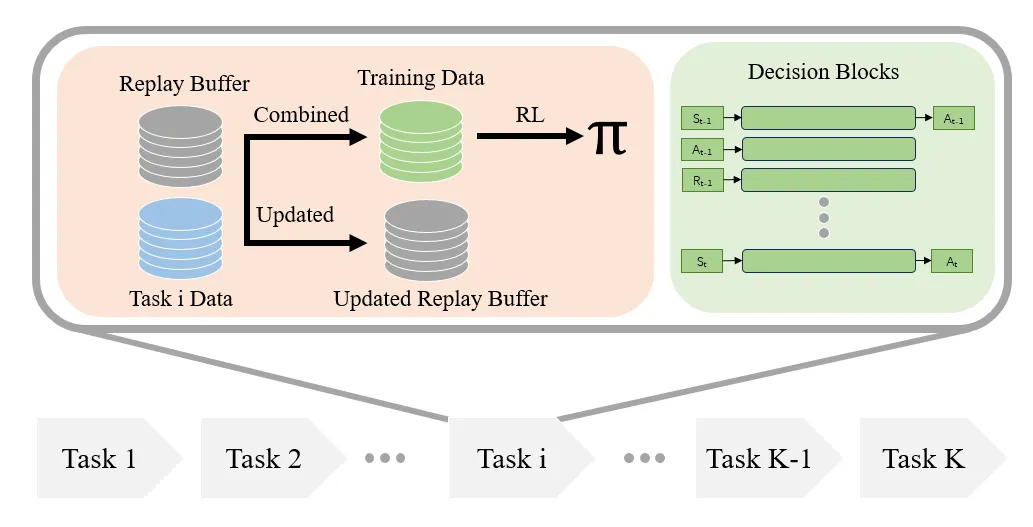

Decision-RWKV

南方科技大学的研究团队提出了 Decision-RWKV (DRWKV) 模型,并将经验回放(experience replay)的概念与 Decision-RWKV 模型相结合,设计出适合机器人的终身学习算法。

实验结果显示 DRWKV 模型在单任务测试和终身学习场景中拥有先进的性能。与此同时, Decision-RWKV 相比 DT(Decision-Transformer)显著地减少了推理时间和内存占用,使其成为现实应用(尤其是机器人领域)的更佳选择。

相关链接:

- Decision-RWKV 论文地址:https://arxiv.org/abs/2407.16306

- Decision-RWKV GitHub 仓库:https://github.com/ancorasir/DecisionRWKV

8 月预告

RWKV 小说模型

据可靠消息,专用于写小说的 RWKV 小说微调模型(7B、14B)正在训练中,敬请期待!

关于《RWKV 社区动态》栏目

《RWKV 社区动态》栏目会不定期播报 RWKV 社区的最新消息,以帮助 RWKV 的关注者、爱好者、开发者更好地了解 RWKV 的发展情况。

《RWKV 社区最新动态》不定期更新,所以请保持关注我们的微信公众号(RWKV 元始智能)、QQ 频道(RWKV)等公开平台,以获取最新的消息。

加入 RWKV 社区

RWKV 是一种创新的深度学习网络架构,它将 Transformer 与 RNN 各自的优点相结合,同时实现高度并行化训练与高效推理。

RWKV 模型架构论文:

-

RWKV-5/6(Eagle & Finch): https://arxiv.org/abs/2404.05892

-

RWKV-4:https://arxiv.org/abs/2305.13048

欢迎大家加入 RWKV 社区,可以从 RWKV 中文官网了解 RWKV 模型,也可以加入我们的 QQ 频道和群聊,一起探讨 RWKV 模型。

- RWKV 中文官网:https://rwkv.cn/

- QQ 频道:https://pd.qq.com/s/9n21eravc